Linear Regression (선형 회귀) - 5 | Ordinary Least Squares (최소제곱법)

저번 포스트에서는 SST, SSR, SSE의 관계에 대해서 알아보았습니다.

Linear Regression (선형 회귀) - 4 | SST = SSR + SSE

저번 포스트에서는 선형 회귀 모델을 디자인 하는 과정에서 StatsModels 라이브러리를 활용하여 얻을 수 있는 Coefficient Table에 대해서 알아보았습니다. Linear Regression (선형 회귀) -3 | Coefficients Table

code-studies.tistory.com

이번 포스트에서는 3번 포스트에서 알아보던 표에서 아직 다루지 못한 부분들을 알아보고, 최소제곱법을 알아보겠습니다.

coefficient table에 대해서는 기존 포스트에서 다루었으니, 아직 안 보셨다면 보고 오심을 추천합니다.

Linear Regression (선형 회귀) -3 | Coefficients Table

저번 포스트에서는 statsmodels를 활용하여 Simple Linear Regression 모델을 디자인 해 보았습니다. Linear Regression (선형 회귀) - 2 | Simple Linear Regression (단순 선형 회귀)저번 포스트에서는 선형 회귀에서

code-studies.tistory.com

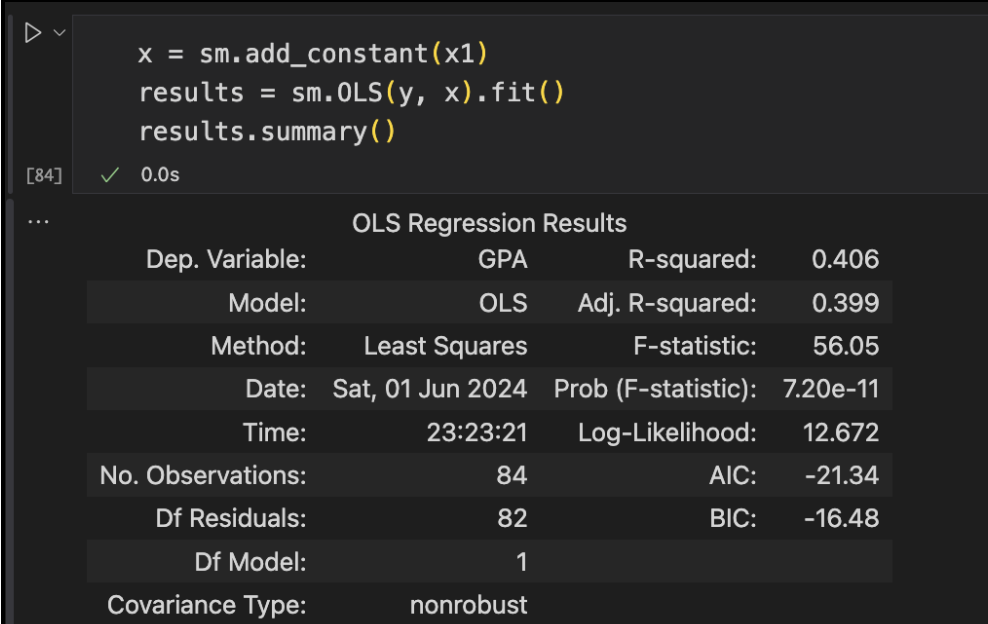

첫번째로 눈에 들어오는 것은 Dep. Variable : GPA 입니다.

Dependent Variable, 종속 변수로 GPA를 설정했다는 점을 보여줍니다.

SAT 점수로 GPA를 예측하는 모델이였던거 기억 나시나요?

정상적으로 코딩을 했는지를 여기서 확인하면 좋겠네요.

다음은 Model: OLS 가 보이네요.

우리의 선형 회귀에서 활용한 모델의 종류를 나타내고, OLS는 Ordinary Least Squares (최소제곱법) 을 나타냅니다.

Model은 한칸 밑의 Method: Least Squares 와 관련이 있습니다.

이번 경우에는 둘이 차이가 아예 없는데, 나중에 더 다양한 모델과 방법들을 다루게되면, 차이를 알 수 있겠습니다.

아무튼 우리의 모델이 최소제곱법을 활용해서 GPA를 예측했다는 뜻인데요, 그렇다면 OLS는 정확히 어떤 방법일까요?

Ordinary Least Squares | 최소 제곱법

저번 포스트에서 다룬 SSE, Sum of Squared Error의 개념 기억나시나요?

Ordniary Least Squares에서 Squares는 이 SSE를 의미합니다.

즉, Least SSE, 모델의 오차의 총 합을 최소한으로 하겠다는 뜻 입니다.

SST = SSR + SSE의 관계에서 SSE가 작아질 수록 SSR은 SST에 근접하고,

이는 모델의 정확도 향상을 의미하는 점. 기억 나시나요?

직관적으로, Lowest SSE를 취하면, 정확도가 최대화 되겠다는 개념입니다.

그래프로 한번 살펴보겠습니다.

SSE의 최솟값 S(b)는 미적분과 선형대수학의 개념을 활용하여 얻게 됩니다.

사실 그냥 수학이기 때문에 손으로도 충분히 구할 수 있는데요, 데이터의 수가 수백, 수천개에서부터 수십만개를 넘는 방대한 양을 다룰때에는 당연히 사람이 손으로 못하겠죠?

그래서 우리가 python을 사용해서 이를 구한 것이고, Excel, SPSS, SAS, Stata같은 소프트웨어로도 구할 수 있고, R과 같은 다른 언어로도 구할 수 있습니다.

여기까지 해서 단순 선형 회귀와 OLS에 대해서 간략하게 알아보았습니다.

당연하게도, OLS 말고도 다양한 회귀 기법들이 존재합니다.

(Generalized Least Squares, Bayesian Regression, Kernel Regression, etc)

하지만 기본적으로 가장 흔하게 쓰이는 회귀 방법은 OLS 기법이고,

우리는 아직 기초 단계이니까 OLS로 만족하는걸로 하겠습니다.

나중에 저도 공부를 많이 해서 더 알게 되면 추가적으로 다루겠습니다.

다음 포스트에서는 단순 선형 회귀의 마지막 포스트로, 결정 계수라고 불리는 R-Squared에 대해서 알아보겠습니다.